안녕하세요, HELLO

오늘은 DeepLearning.AI에서 진행하는 앤드류 응(Andrew Ng) 교수님의 딥러닝 전문화의 두 번째 과정인 "Improving Deep Neural Networks: Hyperparameter Tuning, Regularization and Optimization"을 정리하려고 합니다.

"Improving Deep Neural Networks: Hyperparameter Tuning, Regularization and Optimization"의 강의 목적은 '랜덤 초기화, L2 및 드롭아웃 정규화, 하이퍼파라미터 튜닝, 배치 정규화 및 기울기 검사와 같은 표준 신경망 기술' 등을 배우며, 강의는 아래와 같이 구성되어 있습니다.

~ Practical Aspects of Deep Learning

~ Optimization Algorithms

~ Hyperparameter Tuning, Batch Normalization and Programming Frameworks

"Improving Deep Neural Networks" (Andrew Ng)의 3주차 'Multi-class classification, softmax regression'의 강의 내용입니다.

CHAPTER 1. 'Multi-class classification'

□ softmax regression

Softmax Regression은 Logistic Regression의 일반화된 버전으로, 이진 분류(Binary classification)가 아닌 여러 클래스(multi class)에 예측이 가능할 수 있도록 하는 모델입니다.

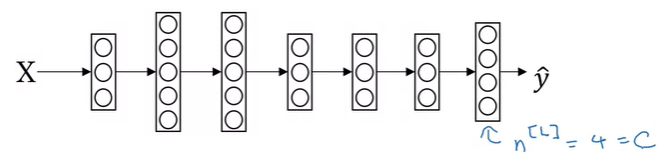

위와 같은 NN(neural network)이 있을 때, output layer의 unit 개수는 4이며, Class, c로 정리됩니다. output layer은 4개의 class들의 확률을 나타내며, 각각의 확률을 전부 더한 class의 전체 확률은 1이 됩니다.

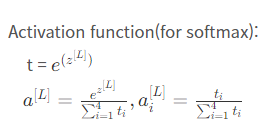

■ softmax layer

소프트맥스 함수는 출력층에서 사용되는 함수입니다. 위에서 정리한 것처럼 소프트맥스 함수는 다중 클래스 분류 모델을 만들 때 사용합니다. 결과를 확률로 해석할 수 있게 변환해주는 함수로, 높은 확률을 가지는 class로 분류합니다. 이는 결괏값을 정규화시키는 것으로도 생각할 수 있다.

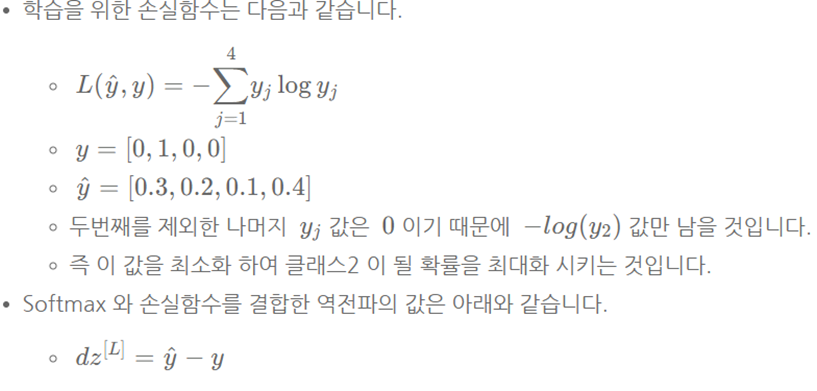

□ Training a softmax classifier

소프트맥스 함수는 로지스틱 회귀 모델을 c개의 class로 일반화합니다. 이때 c=2이면, softmax는 로지스틱 회귀모델로 줄어듭니다(reduce). 이는 결괏값 a [l]이 2개 값이 나오며, 결과적으로 숫자를 산출하는 과정에서 한 개의 결괏값만 나오며 이는 0 또는 1을 결정하는 로지스틱 회귀 모델과 동일한 모습입니다.

손실 함수의 경우, 결괏값 y는 하나만 positive이기에 1을 가지고, 나머지는 0을 가집니다. 전체 트레이닝 세트에 대한 비용 함수는 개별 트레이닝 세트에 따른 모든 비용의 평균을 구하는 것입니다. 그래서 loss function을 최대로 줄이기 위해서는 정답 이외에 해당되는 예측값을 가장 작게 하는 것이 중요합니다.

■ 마무리

"Improving Deep Neural Networks" (Andrew Ng)의 3주차 'Multi-class classification, softmax regression'에 대해서 정리해봤습니다.

그럼 오늘 하루도 즐거운 나날 되길 기도하겠습니다

좋아요와 댓글 부탁드립니다 :)

감사합니다.

'COURSERA' 카테고리의 다른 글

| week 3_Tensorflow introduction 실습 (Andrew Ng) (0) | 2022.02.26 |

|---|---|

| week 3_Hyperparameter Tuning, Batch Normalization and Programming Frameworks 연습 문제 (Andrew Ng) (0) | 2022.02.26 |

| [COURSERA] Structuring Machine Learning Projects (Andrew Ng) (0) | 2022.02.24 |

| week 3_Hyperparameter Tuning, Batch Normalization (Andrew Ng) (0) | 2022.02.24 |

| week 2_Optimization Methods 실습 (Andrew Ng) (0) | 2022.02.20 |

댓글